데이터 전처리

1. numpy로 데이터 준비하기

## 도미 30, 빙어 14

bream_length = [25.4, 26.3, 26.5, 29.0, 29.0, 29.7, 29.7, 30.0, 30.0, 30.7, 31.0, 31.0,

31.5, 32.0, 32.0, 32.0, 33.0, 33.0, 33.5, 33.5, 34.0, 34.0, 34.5, 35.0,

35.0, 35.0, 35.0, 36.0, 36.0, 37.0, 38.5, 38.5, 39.5, 41.0, 41.0]

bream_weight = [242.0, 290.0, 340.0, 363.0, 430.0, 450.0, 500.0, 390.0, 450.0, 500.0, 475.0, 500.0,

500.0, 340.0, 600.0, 600.0, 700.0, 700.0, 610.0, 650.0, 575.0, 685.0, 620.0, 680.0,

700.0, 725.0, 720.0, 714.0, 850.0, 1000.0, 920.0, 955.0, 925.0, 975.0, 950.0]

smelt_length = [9.8, 10.5, 10.6, 11.0, 11.2, 11.3, 11.8, 11.8, 12.0, 12.2,

12.4, 13.0, 14.3, 15.0]

smelt_weight = [6.7, 7.5, 7.0, 9.7, 9.8, 8.7, 10.0, 9.9, 9.8,

12.2, 13.4, 12.2, 19.7, 19.9]

# 데이터셋 통합(도미 + 빙어)

fish_length = bream_length + smelt_length

fish_weight = bream_weight + smelt_weight

import numpy as np

fish_data = np.column_stack((fish_length, fish_weight))

print(fish_data[:3])

print(np.ones(3)) #3개의 1로만 이루어진 배열

fish_target = np.concatenate((np.ones(35), np.zeros(14)))

print(fish_target)

np.concatenate 함수로 두 배열을 이어 붙여 fish_target을 생성한다.

2. 사이킷 런으로 훈련, 테스트셋 나누기

train_test_split()을 이용해 임의로 배열의 요소를 나눈다.

from sklearn.model_selection import train_test_split

train_input, test_input, train_target, test_target = train_test_split(fish_data, fish_target, random_state=42)

print(train_input.shape, test_input.shape)

print(train_target.shape, test_target.shape)

print(test_target)3. 수상한 도미 한마리

도미로 여겨지는 요소에 대해 빙어로 예측함

from sklearn.neighbors import KNeighborsClassifier

kn = KNeighborsClassifier()

kn.fit(train_input, train_target)

kn.score(test_input, test_target)

print(kn.predict([[25, 150]])) #모델의 예측값 [0. ]

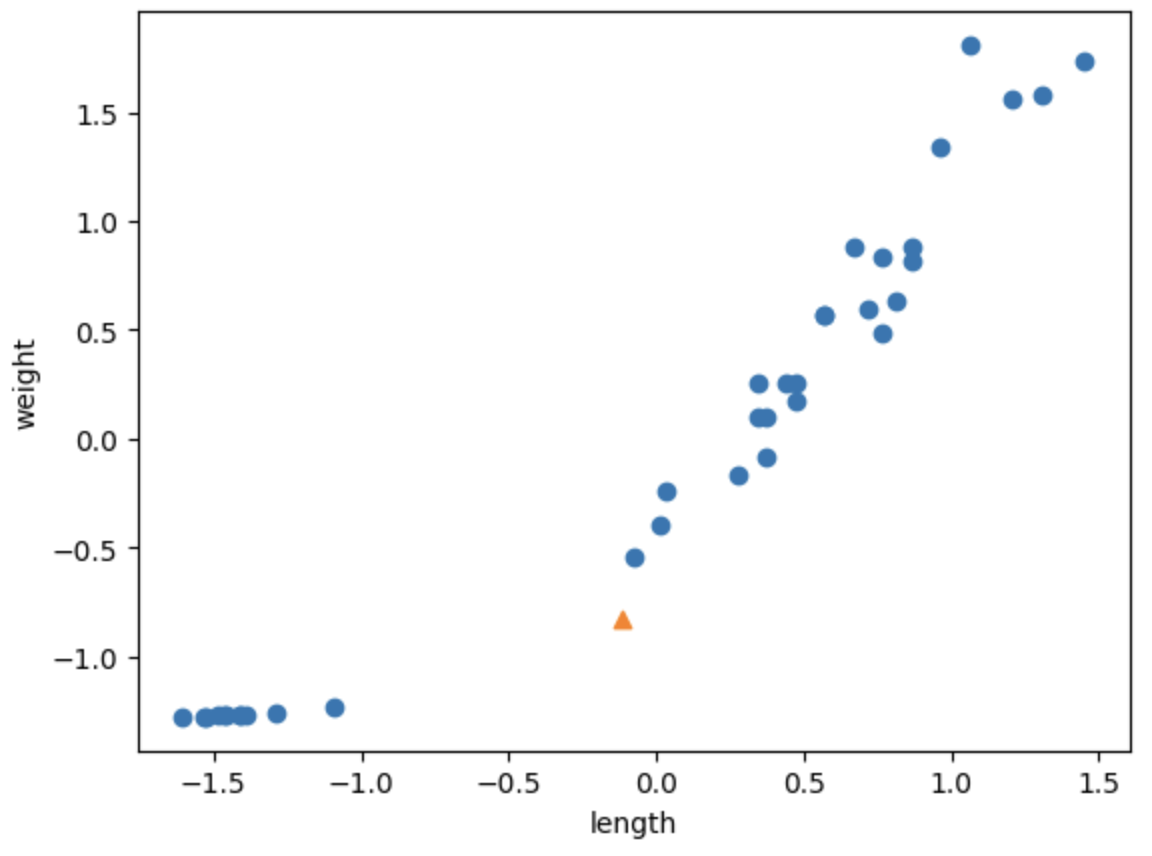

import matplotlib.pyplot as plt

plt.scatter(train_input[:,0], train_input[:,1])

plt.scatter(25, 150, marker='^')

plt.xlabel('length')

plt.ylabel('weight')

plt.show()

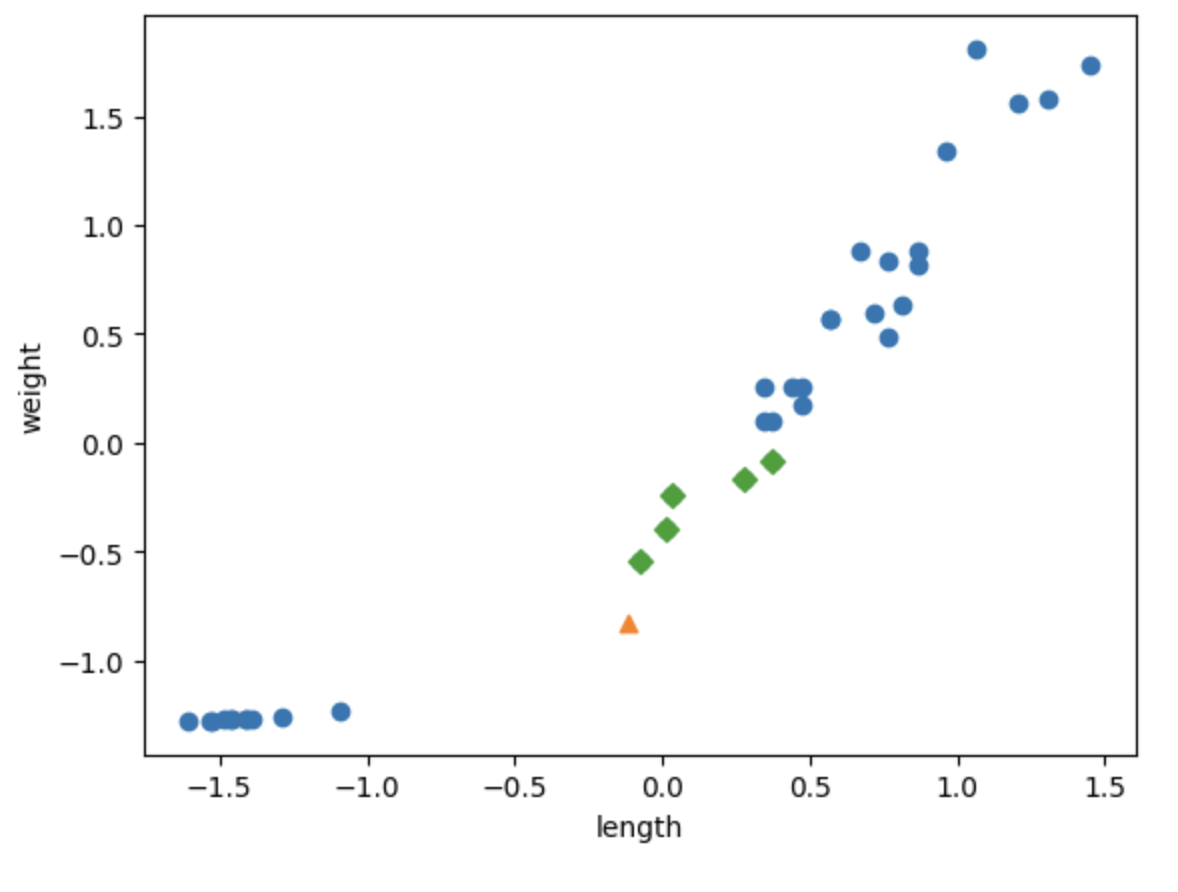

4. 예측에 대한 근거가 되는 점을 표시

sklearn.neighbors.KNeighborsClassifier.kneighbors()

- k개의 이웃점을 찾아 거리를 반환

가장 가까운 데이터 포인트(k개의 이웃)를 찾고, 그들의 속성(라벨)을 바탕으로 새로운 데이터의 결과를 예측하는 것이 K-NN 알고리즘의 핵심

distances, indexes = kn.kneighbors([[25, 150]])

plt.scatter(train_input[:,0], train_input[:,1])

plt.scatter(25, 150, marker='^')

plt.scatter(train_input[indexes,0], train_input[indexes,1], marker='D')

plt.xlabel('length')

plt.ylabel('weight')

plt.show()

distances에는 물고기 길이 25, 무게 150인 데이터 포인트와 가장 가까운 이웃들 사이의 거리가 담기고, indexes에는 그 이웃들의 인덱스(위치)가 담긴다.

- distances: [0.5, 1.2, 1.8] (예시)

→ 주어진 포인트와 가장 가까운 3개의 이웃들과의 거리. - indexes: [10, 20, 5] (예시)

→ 가장 가까운 3개의 이웃들이 학습 데이터에서 위치한 인덱스.

[indexes, 0] -> indexes에 해당하는 행의 첫 번째 열(길이) 정보를 가져옴

[indexes, 1] -> indexes에 해당하는 행의 두 번째 열(무게) 정보를 가져옴

[[[ 25.4 242. ] [ 15. 19.9] [ 13. 12.2] [ 26.3 290. ] [ 11.8 10. ]]]

[[1. 0. 0. 1. 0.]]

[[ 92.00086956 130.48375378 138.32150953 140.00603558 140.62090883]]

x축을 기준으로 데이터 재배치

- x축의 범위(10 ~ 40)가 y축의 범위(0 ~ 1000)보다 현저히 작아서 발생하는 오류

- x축 값을 y축과 동일하게 설정

- 동일 조건에서 데이터 분포도 확인

plt.scatter(train_input[:,0], train_input[:,1])

plt.scatter(25, 150, marker='^')

plt.scatter(train_input[indexes,0], train_input[indexes,1], marker='D')

#좌표축의 x 값을 제한된 값으로 설정함

plt.xlim((0,1000))

plt.xlabel('length')

plt.ylabel('weight')

plt.show()

스케일과 표준점수(z 점수)

스케일링 : 머신러닝에서 데이터의 각 특성(피처)을 일정한 범위로 변환하는 과정

특성 간의 값의 범위가 큰 차이가 나면, 값이 큰 특성이 거리 계산에서 더 큰 영향을 미치게 되어, 모델이 부정확한 예측을 할 수 있다.

예를 들어, 하나의 특성은 0에서 1 사이의 값을 갖고, 다른 특성은 1000에서 10000 사이의 값을 가진다면, 후자가 거리 계산에서 지배적 역할을 하게 된다.

모든 특성의 값을 일정한 범위로 조정하여 각 특성이 동등한 비중을 가지도록 만드는 것

mean = np.mean(train_input, axis=0) #지정된 값에 대한 평균 계산

std = np.std(train_input, axis=0) #지정된 값에 대한 표준편차 계산

#mean = 26.175 418.08888889

#std = 10.21073441 321.67847023

print(mean, std)

train_scaled = (train_input - mean) / std

데이터 전처리 적용

예측 값도 표준점수로 환산하여 예측한다

- 표준화는 각 데이터 포인트에서 평균을 빼고 표준 편차로 나누는 것

new = ([25, 150] - mean) / std #새로운 데이터 포인트

plt.scatter(train_scaled[:,0], train_scaled[:,1])

plt.scatter(new[0], new[1], marker='^')

plt.xlabel('length')

plt.ylabel('weight')

plt.show()

kn.fit(train_scaled, train_target)

test_scaled = (test_input - mean) / std

kn.score(test_scaled, test_target)

- train_scaled : 평균과 표준 편차를 사용하여 정규화된 학습 데이터

- train_target : 학습 데이터에 대한 타겟.

- test_scaled : 정규화된 테스트 데이터

모델의 일반화 능력 확인 -> 머신러닝 모델이 훈련 데이터에만 잘 작동하는 게 아니라, 보지 못한 새로운 데이터에서도 얼마나 잘 작동하는지 나타내는 개념

#길이 25, 무게 150 생선을 표준점수 기준으로 예측 -> 도미로 예측

print(kn.predict([new]))

정규화 된 데이터 세트를 통해 거리와 무게를 공정하게 평가한다. 수상한 생선 데이터를 넣고 다시 그래프를 그려보면 이번엔 가장 가까운 이웃들이 도미 데이터 쪽에 있는 걸 확인 가능하다.

# 새로운 데이터 포인트 new와 가장 가까운 k개의 이웃 찾기

distances, indexes = kn.kneighbors([new])

plt.scatter(train_scaled[:,0], train_scaled[:,1])

#새로운 데이터 포인트 표시

plt.scatter(new[0], new[1], marker='^')

# 가장 가까운 이웃 데이터 표시

plt.scatter(train_scaled[indexes,0], train_scaled[indexes,1], marker='D')

plt.xlabel('length')

plt.ylabel('weight')

plt.show()

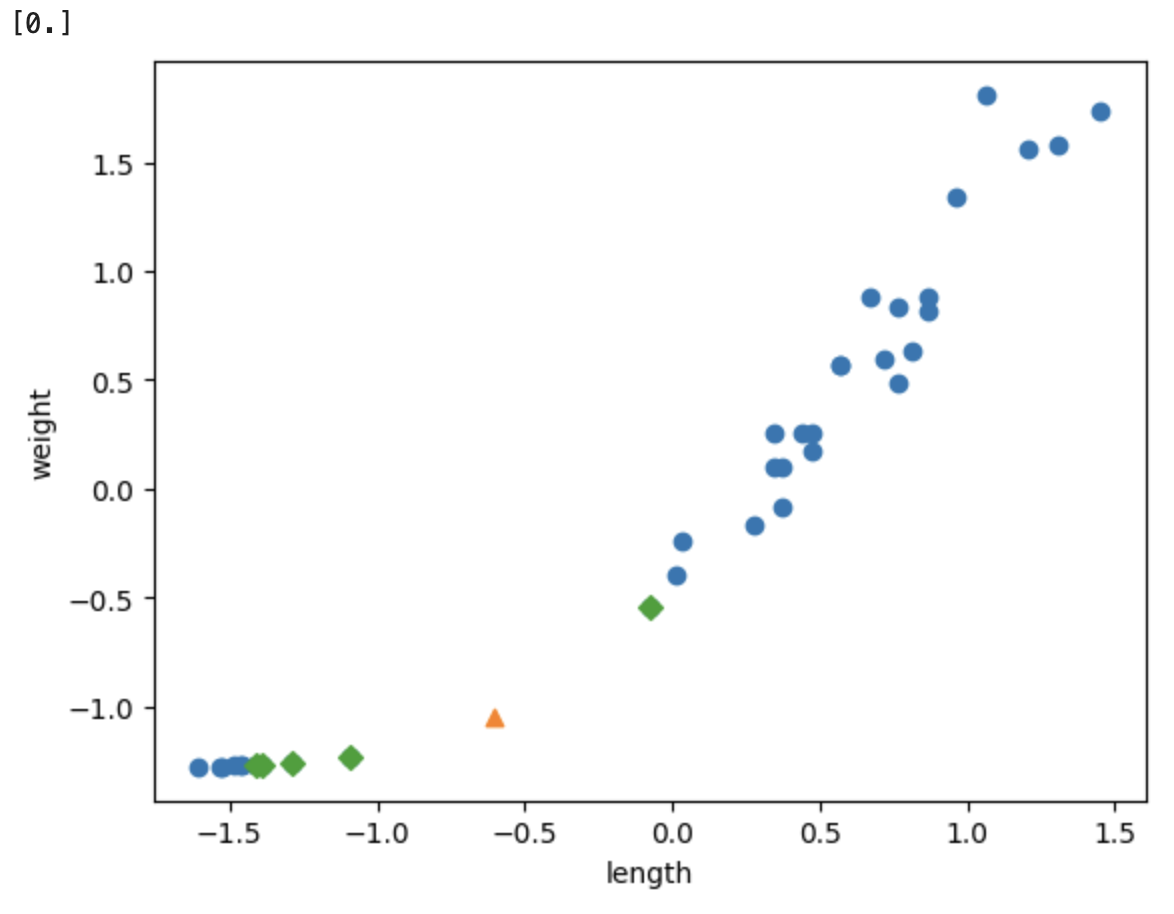

길이가 20, 무게가 80인 생선 예측하고 근거 표시

new = ([20, 80] - mean) / std

kn.fit(train_scaled, train_target)

test_scaled = (test_input - mean) / std

kn.score(test_scaled, test_target)

#길이 20, 무게 80 생선을 표준점수 기준으로 예측 -> 빙어로 예측 [0.]

print(kn.predict([new]))

distances, indexes = kn.kneighbors([new])

#훈련 데이터 전체를 파란 점으로 그림

plt.scatter(train_scaled[:,0], train_scaled[:,1])

#새로운 데이터 포인트 new를 삼각형(marker='^')으로 시각화

plt.scatter(new[0], new[1], marker='^')

# 가장 가까운 이웃점들을 마름모(marker='D')로 표시

plt.scatter(train_scaled[indexes,0], train_scaled[indexes,1], marker='D')

plt.xlabel('length')

plt.ylabel('weight')

plt.show()

표준 점수 기반 데이터 전처리를 진행해봤다.